Besz√©lt √©s √≠rott magyar sz√∂veg feldolgoz√°s√°t lehetŇĎv√© tevŇĎ modellt √©p√≠tettek a P√©csi Tudom√°nyegyetemen

2021. augusztus 27.

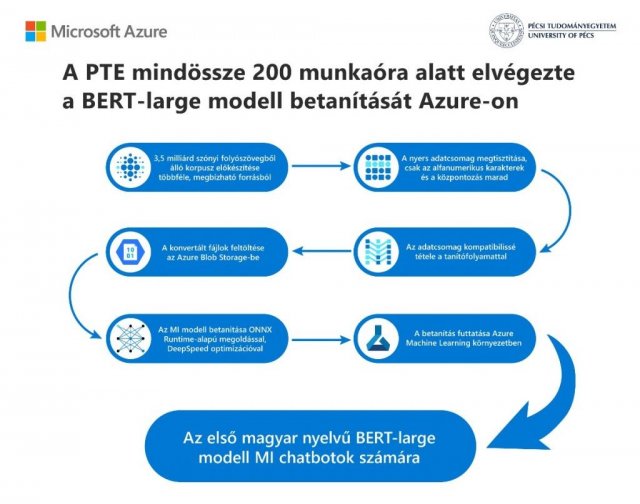

Mindenki szívesebben használja az anyanyelvét chat és más automatizált alkalmazásokban. Mivel azonban a magyar nyelvet mindössze 15 millióan beszélik világszerte, a cégek számára gyakran nem éri meg kifejleszteni a feldolgozásához szükséges szoftvereket. A Pécsi Tudományegyetem (PTE) Alkalmazott Adattudományi és Mesterséges Intelligencia-csapata felismerve ezt a problémát a Microsoft Azure mesterséges intelligencia és az ONNX Runtime megoldások alkalmazásával megépítette és betanította saját BERT-large modelljét magyar nyelven, méghozzá kevesebb, mint 200 munkaóra és 1000 euró befektetésével.

A Pécsi Tudományegyetem számára kulcsfontosságú terület lett a mesterséges intelligencia és a felhŇĎalapú oktatás, amióta partnerkapcsolatot építettek ki a Microsoft Mesterséges Intelligencia Tudásközpont program keretein belül 2019-ben.

A nagy mennyiségŇĪ magyar nyelvŇĪ adat kezelését megkönnyítendŇĎ a PTE természetes nyelvfeldolgozási (NLP) módszerek kutatásába fogott. A megoldást egy magyar nyelvŇĪ BERT-large modell (HILBERT) létrehozása jelentette, ami egy nyílt forráskódú gépi tanulás keretrendszer. A modell célja, hogy segítse a számítógépet a többféleképpen értelmezhetŇĎ szövegrészek megértésében oly módon, hogy a szövegkörnyezetbŇĎl kontextust épít.

A csapat az Azure mesterséges intelligencia használata mellett döntött a saját, magyar nyelvŇĪ BERT-large modelljük megalkotásához.

“A Microsoft piacvezetŇĎ a nyelvi modellek betanításának területén. Természetes, hogy a legjobb technológiát akartuk használni” – mondta el Hajdu Róbert, az Alkalmazott Adattudományi és Mesterséges Intelligencia Központ volt tervezŇĎmérnöke. Ráadásul a csapat már ismerte az Azure szolgáltatást, ez is egy érv volt mellette.

Ahelyett, hogy gyenge minŇĎségŇĪ adatokat gyŇĪjtöttek volna az internetrŇĎl, a Nyelvtudományi Kutatóközpont szakemberei segítségével készítették elŇĎ az alapokat. Az Azure pedig mindent megkönnyített és felgyorsított.

A modell betanítására szintén gyors és költséghatékony megoldást kerestek: a Microsoft ONNX Runtime DeepSpeed könyvtárát választották a feladathoz, amit az Azure Machine Learning (AML) platformon futtattak. E platform segítségével hatékonyan tudtak haladni a mesterséges intelligencia modellek építésével, munkába állításával, menedzsmentjével és nyomonkövetésével. Így a csapat közben olyan más feladatokra koncentrálhatott, mint például az adatkezelés.

A modell mŇĪködéséhez egyébként legalább 3,5 milliárd szót tartalmazó folyószöveg szükséges, ezt az adatbázist a Nyelvtudományi Kutatóközpont, a projekt másik résztvevŇĎje többek között a Magyar Nemzeti Szótárból, online médiatárakból és az opensubtitles.org ingyenesen hozzáférhetŇĎ filmfelirat-adatbázis magyar nyelvŇĪ anyagai közül gyŇĪjtötte a csapat.

Habár a pandémia alatt mindannyian otthonról dolgoztak, a BERT-large betanítási folyamata az Azure-on semmilyen problémát nem okozott.

“200 munkaóra alatt végeztünk. Ez a világon az eddigi legolcsóbb BERT-large. Kevesebb, mint 1000 euróba került” – mesélte büszkén Dr. Feldmann Ádám, a PTE Adattudományi és AI csoport vezetŇĎje. “Az ONNX Runtime nélkül a HILBERT-large modellünk betanítása 1500 órát, vagyis megközelítŇĎleg két hónapot vett volna igénybe” – hívja fel a figyelmet.

A Pécsi Tudományegyetem BERT-large modellje jelentŇĎs lehetŇĎségeket rejt magában az írott és beszélt szöveg feldolgozása, az intelligens keresés, az entitásérzékelés, a dokumentációs klasszifikáció terén. A HILBERT közremŇĪködhet újabb, jobb teljesítményŇĪ chatbotok létrehozásában is.

Mindez pedig segítheti a magyarokat a könnyen érthetŇĎ, releváns információkhoz való hozzáférésben, különösen a Covid-19 körüli félretájékoztatás elleni küzdelemben. Számos egészségügyi és kormányzati szereplŇĎ is érdeklŇĎdött már a HILBERT-large modell iránt.

A projekt teljes ismertetŇĎje ezen a linken olvasható.

Kapcsolódó cikkek

- N√©met mŇĪv√©sz √©rkezik a SZTAKI-ba, hogy robotot √©p√≠tŇĎ robotot √©p√≠tsen

- A Xiaomi √∂t √ļj okoseszk√∂zt mutatott be

- Mesterséges intelligencia a mindennapok szolgálatában

- A Dell Technologies Omnia szoftverével felgyorsíthatók az innovációs folyamatok

- Az adathal√°szat √°ltal legjobban s√ļjtott brand tov√°bbra is a Microsoft

- A hibrid munkak√∂rnyezet t√∂bb √©rz√©kenys√©get √©s rugalmass√°got k√≠v√°n meg a vezetŇĎktŇĎl

- A j√∂vŇĎ AI alap√ļ ell√°t√°si l√°ncai most alakulnak

- A Fujitsu mesters√©ges intelligenci√°ja vigy√°zza a N√ľrburgring versenyp√°lya biztons√°g√°t

- OMSZ‚ÄďDyntell: l√°tj√°k a j√∂vŇĎt

- Digitális készségekkel vértezte fel magát a hazai civil szektor